老子曰:持续保持对新事物的兴趣,能够延缓衰老。

”

前天提到可以使用Ollama在本地电脑上部署大模型并离线使用(见一条命令完成本地版大模型下载及安装使用)。Ollama只是一个加载大模型的框架而已,其实类似的框架在github上还可以找到一堆,目前比较热的比如LM Studio也还挺好用,不过我最喜欢Ollama的一点是其静默启动,在需要大模型的时候才加载模型,非常轻巧和易于部署。

部署了大模型,当然是要使用。有人说GPT4不好用么,Windows Copilot不好用么,这些虽然功能强大,但有时候访问不太方便。那国内模型呢?国内模型的表现目前做一些文字性工作还不错,不过涉及到一些逻辑性和精确性要求比较高的数理问题就捉襟见肘了。当然利用国内大模型做一些文字润色、语言翻译还是相当的哇塞的。但这些大模型并不掌握在自己手里,没准今天用的非常爽的模型明天就让你交钱了,所以一些开源的大模型还是值得使用的。

对中文支持比较好的开源大模型推荐阿里的Qwen和智谱的ChatGLM3,个人强烈推荐Qwen。

有了大模型,后续当然是建立在大模型基础上的应用了。我们可以在大模型的基础上基于langchain构建私有知识库,也可以利用这些大模型做一些文字性的工具开发。这类工具其实编制起来很简单,无非是调用大模型提供的接口,再加入一点提示词即可。

比如今天要推荐的开源项目OpenAI Translator。

github地址:https://github.com/openai-translator/openai-translator

”

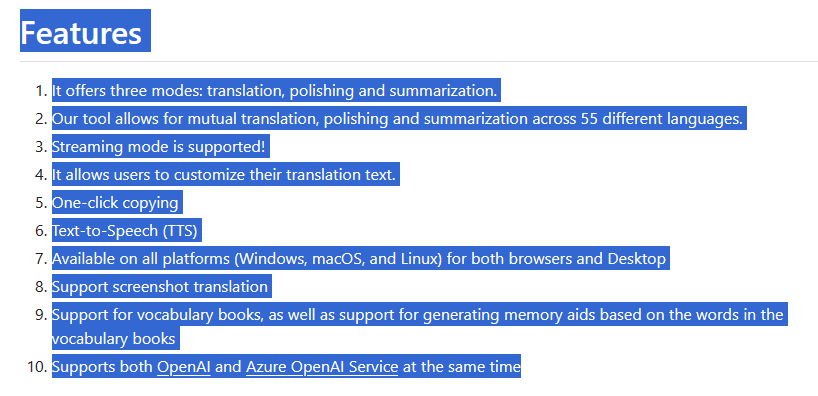

OpenAI Translator起初是想使用ChatGPT实现划词翻译的。不过目前已经发展成可以加载一些本地部署的大模型了。

1 安装

OpenAI Translator提供了全平台支持,甚至包括浏览器插件。这里以windows系统为例。

下载地址:https://github.com/openai-translator/openai-translator/releases/tag/v0.3.24

”

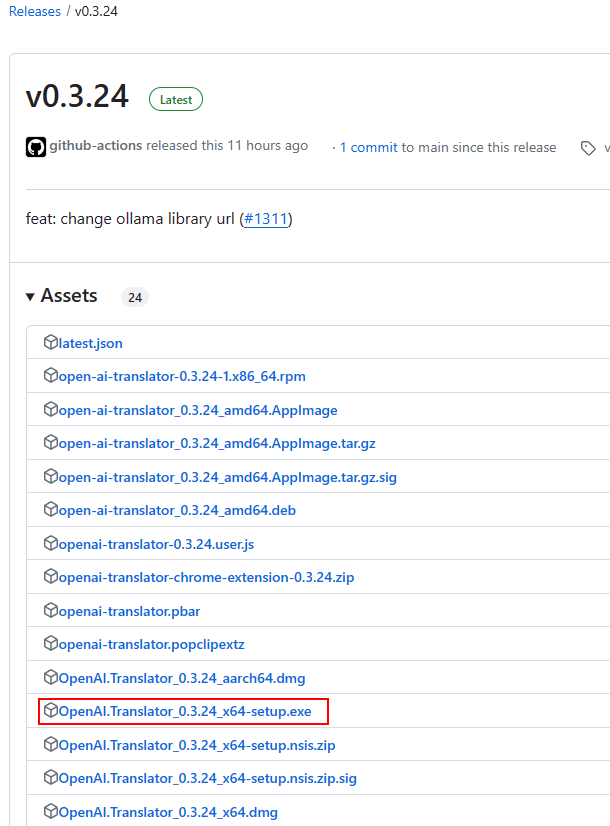

进入下载地址,选择下载适合的安装程序,如下图所示。

安装过程没啥好说的,双击安装程序即可。

2 配置

首先确保本机上已经启动了Ollama,且Ollama已经提前部署了大模型。这里以qwen:7b为例。

-

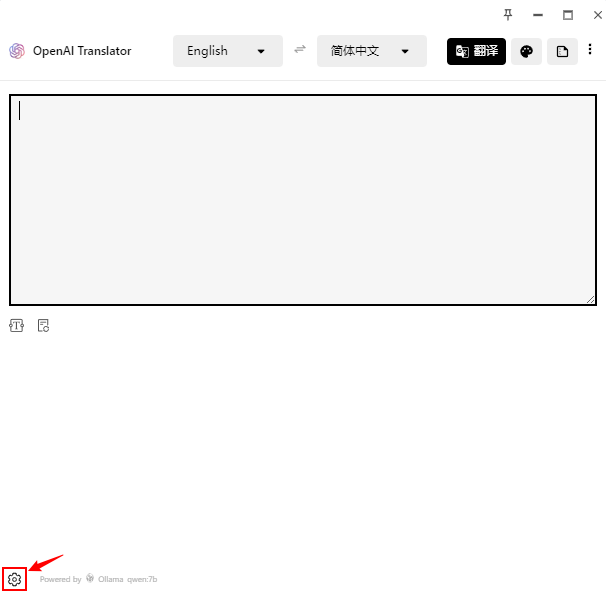

启动OpenAI Translator,点击左下角的设置按钮。

-

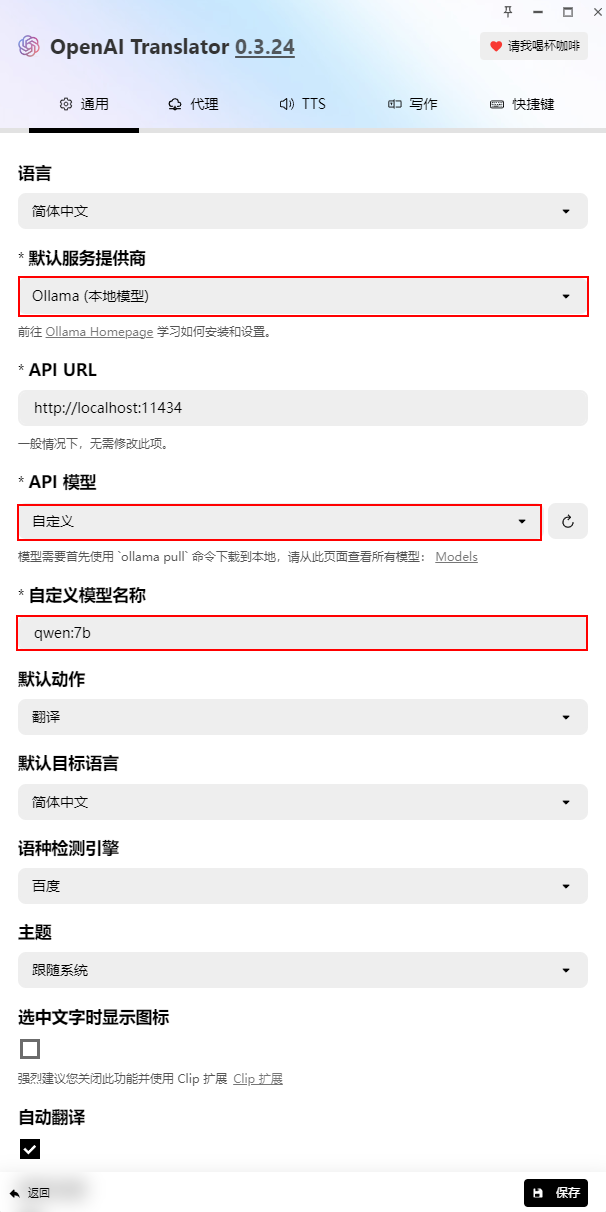

在通用选项卡中进行设置 -

指定 默认服务提供商为 Ollama(本地模型) -

指定 API模型为 自定义 -

指定 自定义模型名称为 qwen:7b

这里要注意自定义模型名称必须与Ollama启动的模型名称保持一致,否则会找不到模型。

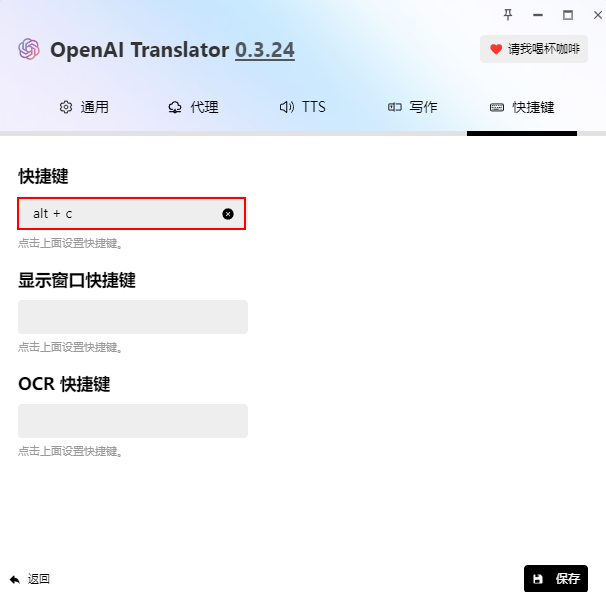

为方便使用,可以设置快捷键。

-

进入 快捷键选项卡,如图所示设置快捷键

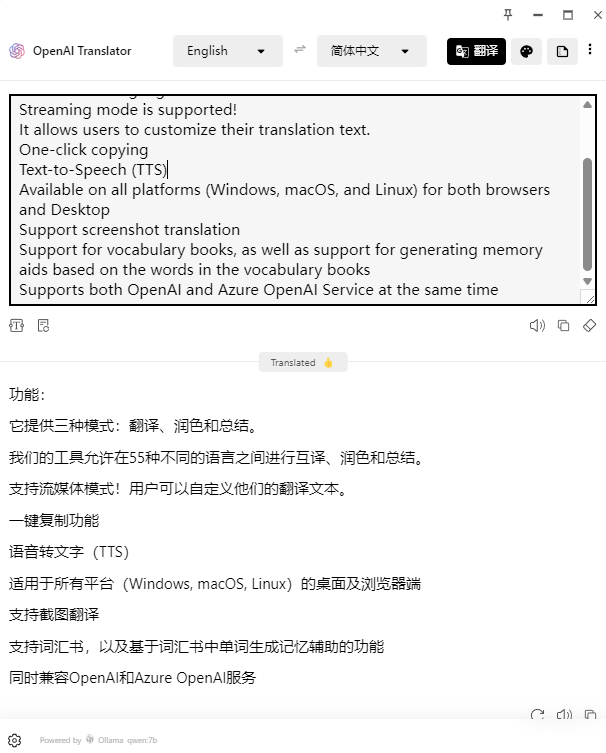

随便找段英文尝试一下。

-

选择英文,按前面设置的快捷键(如上图设置的alt+c)

快捷键会唤醒OpenAI Translator并将自动翻译选择的文字。翻译速度超级快,从下图可以看出,翻译质量也相当的不错。

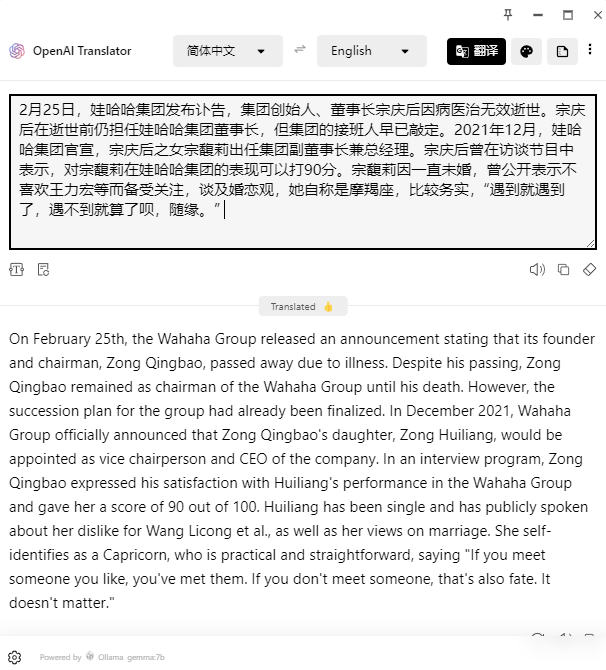

再来段中译英试试。来个英文扎实的道友评价一下翻译效果怎样。

qwen:7的中译英效果不咋地,有时候翻译结果中会有中文字,虽然多翻译几次能消除,但还是不爽。不过好在可以换其他的模型。下面是谷歌前几天开源的Gemma翻译的结果,虽然翻译结果中不会出现中文,但从下面的结果来看,Gemma似乎识字不多,两个人名字都认错。个人觉得qwen翻译更地道,从最后一句感觉到的。

OpenAI Translator除了能够提供翻译功能外,还提供了基于大模型的文字生成及润色功能,有兴趣的道友可自行探索。如果编程能力还不错的话,完全可以自行编制类似的工具,这只是一个简单的调用接口的外壳而已。

受制于硬件资源,本地能够部署的大模型参数量都比较小,功能和性能都无法与头部厂家提供的模型相比,但本地模型主打一个安全和快速响应,可玩性也更强。不过从目前内卷现象来看,开源模型的性能必然也会快速提升,现在很多7B的模型在一些特殊领域的表现已经不输于当初的GPT3.5了。

(完)

本篇文章来源于微信公众号: CFD之道

评论前必须登录!

注册